Оптимизация краулингового бюджета

- Как узнать, какое количество страниц могут проиндексировать поисковые системы?

- Как оптимизировать краулинговый бюджет

«Краулинговый бюджет» — термин, подразумевающий количество страниц, которые может просканировать поисковый робот за одну сессию визита на сайт.

Для сайтов с большим количеством целевых страниц скорость сканирования и индексации является крайне важным параметром, так как от нее зависит, насколько быстро в индекс поисковых систем попадут новые страницы или обновятся изменения на уже проиндексированных.

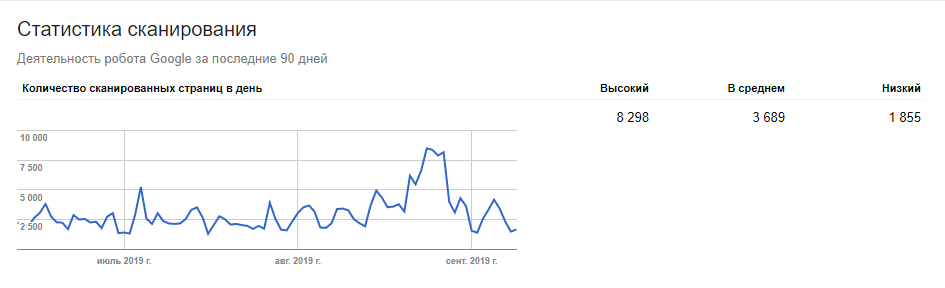

Пример статистики сканирования сайта поисковым роботом Google:

Сайт из примера содержит около 48 тысяч посадочных страниц.

Нетрудно посчитать, что сканирование всех страниц сайта произойдет примерно через 13 дней. Отметим, что ситуация усугубляется установленными приоритетами на индексацию страниц, частотой их обновления и уровнем вложенности самих страниц. Как результат, часть страниц будет просканирована поисковым роботом значительно позже.

Краулинговый бюджет рассчитывается для каждого сайта индивидуально, но точная формула, к сожалению, неизвестна.

Как узнать, какое количество страниц могут проиндексировать поисковые системы?

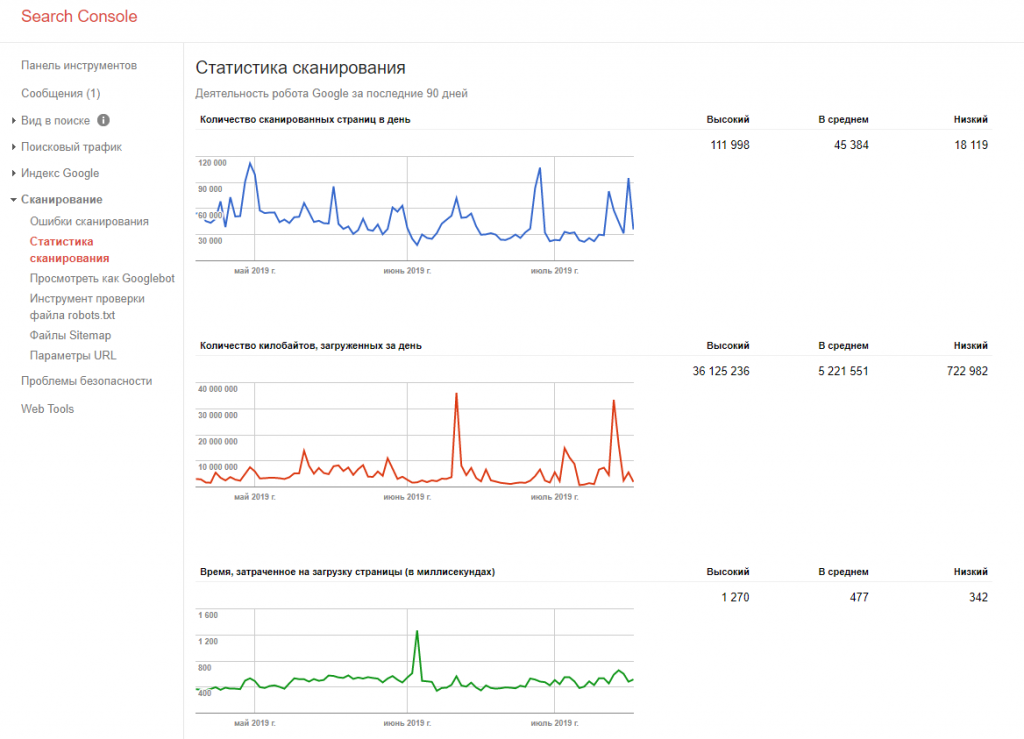

Для поисковой системы Google можно узнать примерное количество страниц, сканируемых поисковым роботом, с помощью сервиса Google Search Console (на момент написания статьи — старой версии): раздел «Сканирование – статистика сканирования» («Crawl – crawl status»).

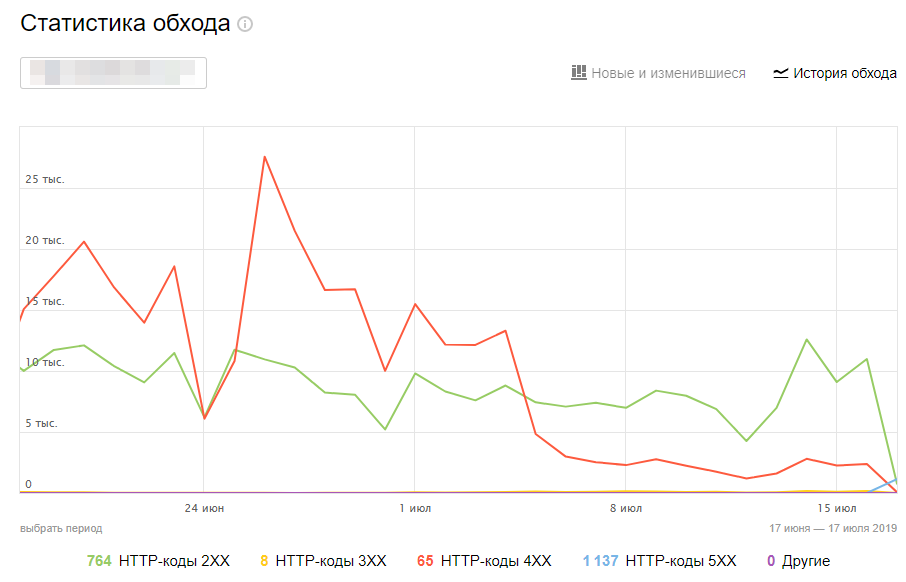

Статистика по сканированию страниц поисковым роботом «Яндекса» доступна в сервисе «Яндекс.Вебмастер», в разделе «Индексирование» –> «Статистика обхода»

Как оптимизировать краулинговый бюджет

Оптимизация краулингового бюджета является крайне важным аспектом поисковой оптимизации для сайтов с большим количеством страниц.

В целом оптимизацию можно разделить на работы двух типов:

-

Оптимизация краулингового бюджета с помощью уменьшения общего количества страниц, которые будут обнаружены и проиндексированы поисковым роботом.

- Удаление технических дублей страниц, которые генерируются множеством популярных CMS.

- Удаление внутренних ссылок, целевые страницы с которых передают код ответа «404».

- Удаление цепочек редиректов и циклических ссылок.

- Уменьшение количества и объема файлов JS и CSS-таблиц.

-

Предоставление поисковым роботам рекомендаций, указывающих, какие страницы необходимо просканировать в первую очередь, а какие — не нужно сканировать.

- Создание в файле robots.txt директив, указывающих на то, какие страницы не должны быть проиндексированы. Используется директива disallow.

- Корректная настройка генерации файлов sitemap. Файлы следует регулярно обновлять, в них должны содержаться ссылки на все страницы сайта, которые должны быть проиндексированы. Крайне не рекомендуется добавлять в файлы sitemap ссылки на страницы сайта, которые передают код ответа, отличный от «200 ОК», или закрыты для индексации в файле robots.txt. Также рекомендуем для всех ссылок указывать корректные данные в тегах <lastmod> — дата последнего изменения страницы, <priority> — приоритетность загрузки и индексации страниц: 0.0 — минимальный приоритет, 1.0 — максимальный приоритет, допускаются промежуточные значения, например 0.7. Тег <priority> поддерживается только ПС «Яндекс».

- Установка корректных правил обхода страниц с GET-параметрами и UTM-метками. Сканирование таких страниц также расходует краулинговый бюджет, но в большинстве случаев они не содержат полезного контента. Для запрета их сканирования используйте директиву clean-param в robots.txt (для ПС «Яндекс») и настраивайте правила сканирования страниц с параметрами в разделе «Параметры URL» в Google Search Console (для ПС Google).

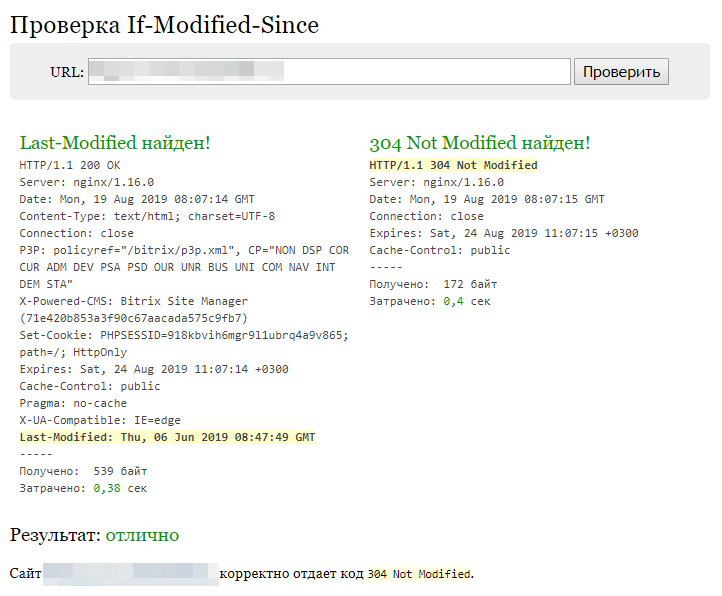

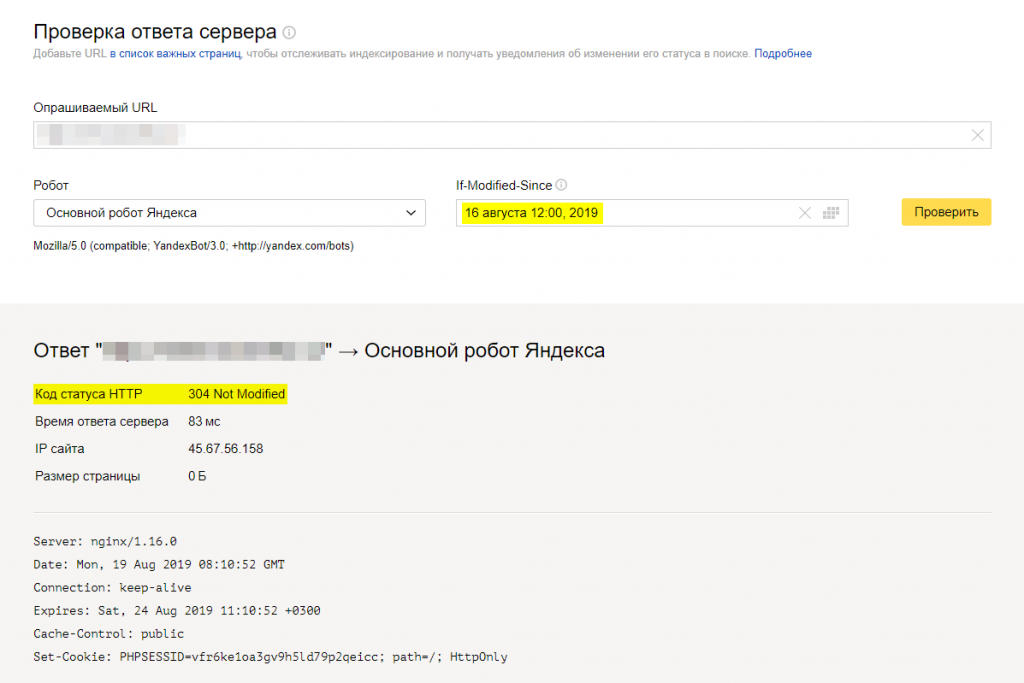

- Настройка передачи всеми страницами сайта заголовка Last-Modified и корректной обработки заголовка If-Modified-Since. Страницы сайта всегда должны передавать клиенту дату последнего обновления в заголовке Last-Modified, а при получении заголовка If-Modified-Since — сравнивать полученную дату с датой последнего изменения страницы. Если страница изменялась в указанный интервал, передавать код ответа «200 ОК» и загружать страницу; если страница не изменялась, передавать код ответа «304» и останавливать загрузку страницы. Для проверки настройки заголовков можно использовать сервис last-modified.com или «Проверка ответа сервера» в панели веб-мастера ПС «Яндекс».

Отметим, что установка атрибута rel=”canonical” в код никак не повлияет на краулинговый бюджет, так как страницы, на которых установлен этот атрибут, все равно будут просканированы поисковыми роботами для проверки отличий от канонической страницы.

Использование тега <meta name="robots" content="noindex" /> (или настройка HTTP-заголовка X-Robots-Tag: noindex) также не повлияет на краулинговый бюджет, потому что тег запрещает индексацию страницы, а не ее сканирование.